AI技术迅猛发展的当下,从深度学习模型训练到实时AI推理应用,对算力的需求呈爆发式增长。与此同时,低延迟的AI算力租赁服务成为众多企业和科研机构的迫切需求,因为哪怕是毫秒级的延迟,都可能在诸如自动驾驶、金融高频交易、远程医疗手术等对实时性要求极高的应用场景中,产生严重后果。在国内的AI算力租赁市场中,龙思云脱颖而出,凭借一系列技术和优化策略,为用户提供低延迟的更好体验。

一、前沿网络架构与传输技术

龙思云构建了的网络架构,在数据中心布局上独具匠心。其在国内多个关键区域设立了数据中心节点,通过高速骨干网络将这些节点紧密相连,形成了一个高效的数据传输网络。以华东地区为例,龙思云在上海、杭州等地的数据中心相互协作,确保当地及周边用户的请求能够在短时间内被响应。当用户发起算力请求时,系统会基于智能路由算法,自动选择距离用户近且负载较低的数据中心节点,大大缩短了数据传输的物理距离。

在传输协议方面,龙思云自主研发了NetRDC传输协议。该协议专门针对AI算力数据传输进行优化,通过采用高效的数据压缩算法,能够在不损失数据精度的前提下,大幅减少数据传输量。同时,NetRDC协议具备强大的纠错和重传机制,即使在网络环境不稳定的情况下,也能确保数据传输的完整性和稳定性,有效避免了因网络波动导致的延迟增加。例如,在处理大规模深度学习模型训练数据时,传统传输协议可能需要数小时才能完成数据上传,而使用NetRDC协议,在同等网络条件下,可将时间缩短至几十分钟,显著提升了数据传输效率,降低了整体延迟。

二、硬件设施与资源调度优化

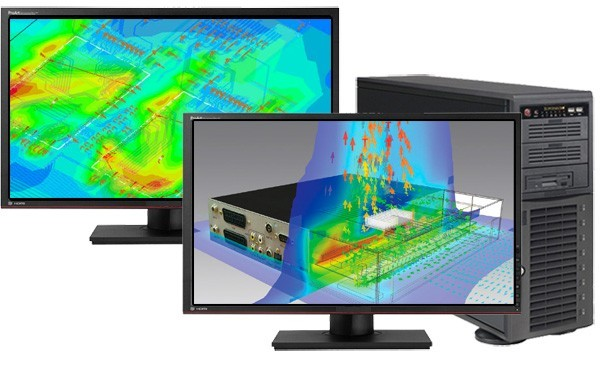

在硬件设施上,龙思云配备了高性能的计算设备。其服务器采用新一代的CPU和GPU,例如英伟达的A100、H100等GPU芯片,这些芯片具备强大的并行计算能力,能够快速处理复杂的AI计算任务。同时,龙思云在数据存储方面采用了基于NVMe协议的高速固态硬盘(SSD),相较于传统机械硬盘,读写速度提升了数倍,使得数据读取和写入的延迟大幅降低。在训练大型语言模型时,快速的数据存储和读取能力能够确保模型参数的快速更新,加速训练进程。

为了进一步提升算力使用效率,降低延迟,龙思云开发了智能资源调度系统。该系统实时监控各个计算节点的资源使用情况,包括CPU使用率、GPU负载、内存占用等。当用户提交AI任务时,调度系统会根据任务的类型、优先级以及各节点的实时资源状况,智能地将任务分配到合适的计算节点上。对于对延迟极为敏感的实时推理任务,调度系统会优先将其分配到资源空闲且性能强劲的节点,确保任务能够得到快速处理。而对于大规模的模型训练任务,系统则会合理分配资源,充分利用集群的计算能力,在保障训练进度的同时,尽可能减少对其他实时任务的影响。

三、分布式计算与边缘计算融合

龙思云积极探索分布式计算与边缘计算技术的融合应用,以降低延迟。在分布式计算方面,龙思云将大型AI计算任务拆分成多个子任务,分发到不同的数据中心节点进行并行处理。这些节点之间通过高速网络进行数据交互和协同计算,将各个子任务的结果汇总得到答案。这种分布式计算模式不仅提高了计算效率,还能有效分散网络负载,减少单个节点的压力,从而降低延迟。

同时,龙思云在边缘计算领域也有所建树。其在靠近用户端的边缘节点部署了一定的计算资源,如在一些城市的核心区域设立了边缘计算站点。对于一些对实时性要求极高的应用,如智能安防监控中的实时目标识别,边缘计算站点可以直接对摄像头采集的数据进行初步处理和分析,快速识别出目标物体,并将关键信息及时反馈给用户。只有在遇到复杂问题需要更强大的计算能力时,才会将数据上传至核心数据中心进行进一步处理。这种边缘计算与核心数据中心相结合的模式,大大减少了数据在网络中的传输距离和时间,有效降低了延迟,为用户提供了近乎实时的AI服务体验。

凭借网络架构、高性能的硬件设施、智能的资源调度以及创新的分布式与边缘计算融合技术,龙思云在国内AI算力租赁市场中,为用户提供了低延迟的服务。